PyTorch Recipes

译者:片刻小哥哥

项目地址:https://pytorch.apachecn.org/2.0/tutorials/recipes/recipes_index

原始地址:https://pytorch.org/tutorials/recipes/recipes_index.html

Recipes 是关于如何使用特定 PyTorch 功能的简短、可操作的示例,与我们的完整教程不同。

-

在 PyTorch 中加载数据

-

定义神经网络

-

PyTorch 中的 state_dict 是什么

-

在 PyTorch 中保存和加载模型以进行推理

-

在 PyTorch 中保存和加载常规检查点

-

使用 PyTorch 在一个文件中保存和加载多个模型

-

使用 PyTorch 中不同模型的参数热启动模型

-

在 PyTorch 中跨设备保存和加载模型

-

在 PyTorch 中将梯度归零

-

PyTorch 基准测试

-

PyTorch 基准测试(快速入门)

-

PyTorch Profiler

-

PyTorch Profiler 具有仪器和跟踪技术 API (ITT API) 支持

了解如何将 PyTorch 的分析器与仪器和跟踪技术 API (ITT API) 结合使用,以可视化英特尔® VTune™ Profiler GUI 中的操作员标签

-

Torch 编译 IPEX 后端

-

在 PyTorch 中推理形状

-

从检查点加载 nn.Module 的提示

-

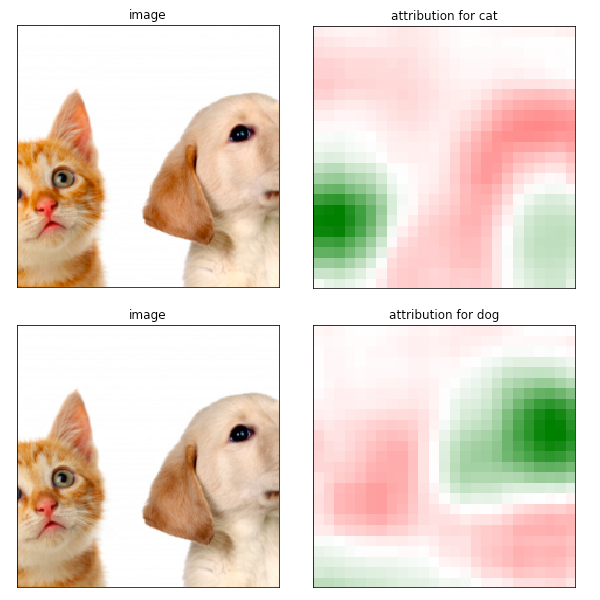

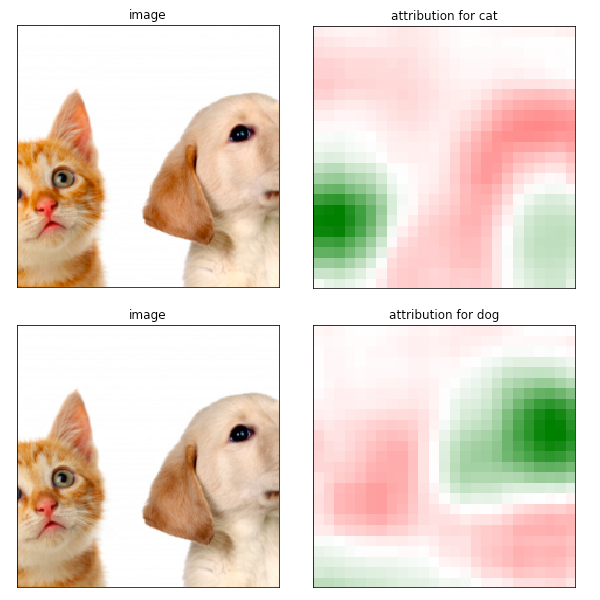

使用 Captum 进行模型解释

-

使用 ZeroRedundancyOptimizer 的分片优化器状态

-

使用 TensorPipe RPC 进行直接设备间通信

-

支持 TorchScript 的分布式优化器

-

分布式检查点 (DCP) 入门

-

使用 Captum 进行模型解释

-

PyTorch Mobile 性能秘诀

-

制作使用 PyTorch Android 预构建库的 Android 本机应用程序

了解如何从头开始制作使用 LibTorch C++ API 并使用 TorchScript 模型和自定义 C++ 运算符的 Android 应用程序

-

Fuse Modules Recipe

-

Mobile Recipes 的量化

-

针对移动设备编写脚本并进行优化

-

iOS Recipes 的模型准备

-

Android Recipes 的模型准备

-

Android 和 iOS 中的 Mobile Interpreter 工作流程

-

动态量化

-

PyTorch Mobile 性能秘诀

-

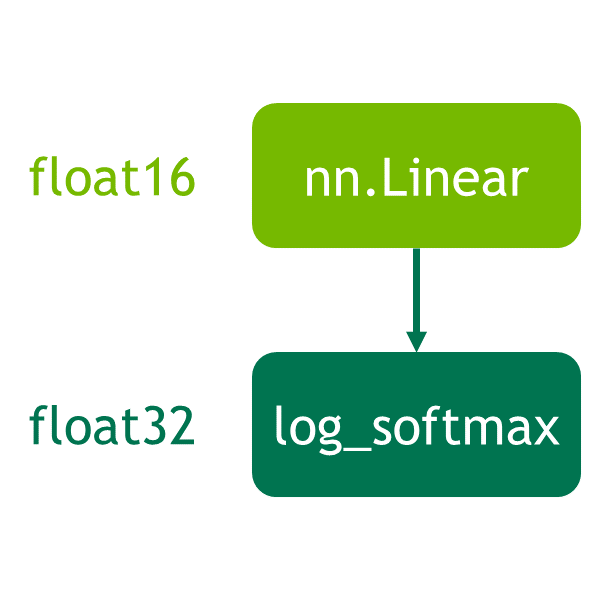

自动混合精度

-

性能调优指南

-

利用英特尔® 高级矩阵扩展

-

适用于 PyTorch 的英特尔® 扩展

-

适用于 PyTorch 的英特尔® 神经压缩器

-

使用 Flask 进行部署

-

分析基于 PyTorch RPC 的工作负载

-

将 PyTorch Stable Diffusion 模型部署为 Vertex AI 端点

-

动态量化

-

Mobile Recipes 的量化

-

适用于 PyTorch 的英特尔® 神经压缩器

-

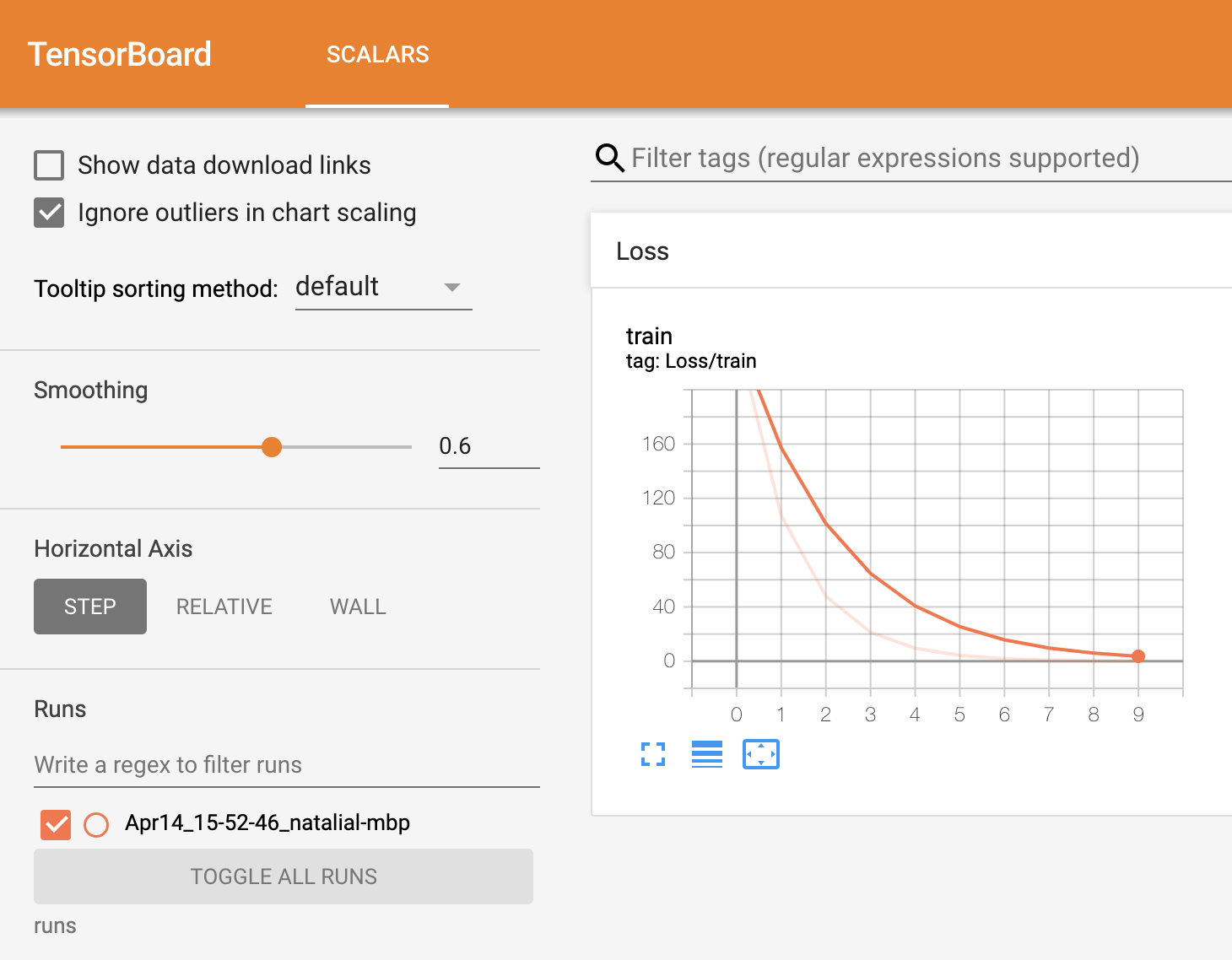

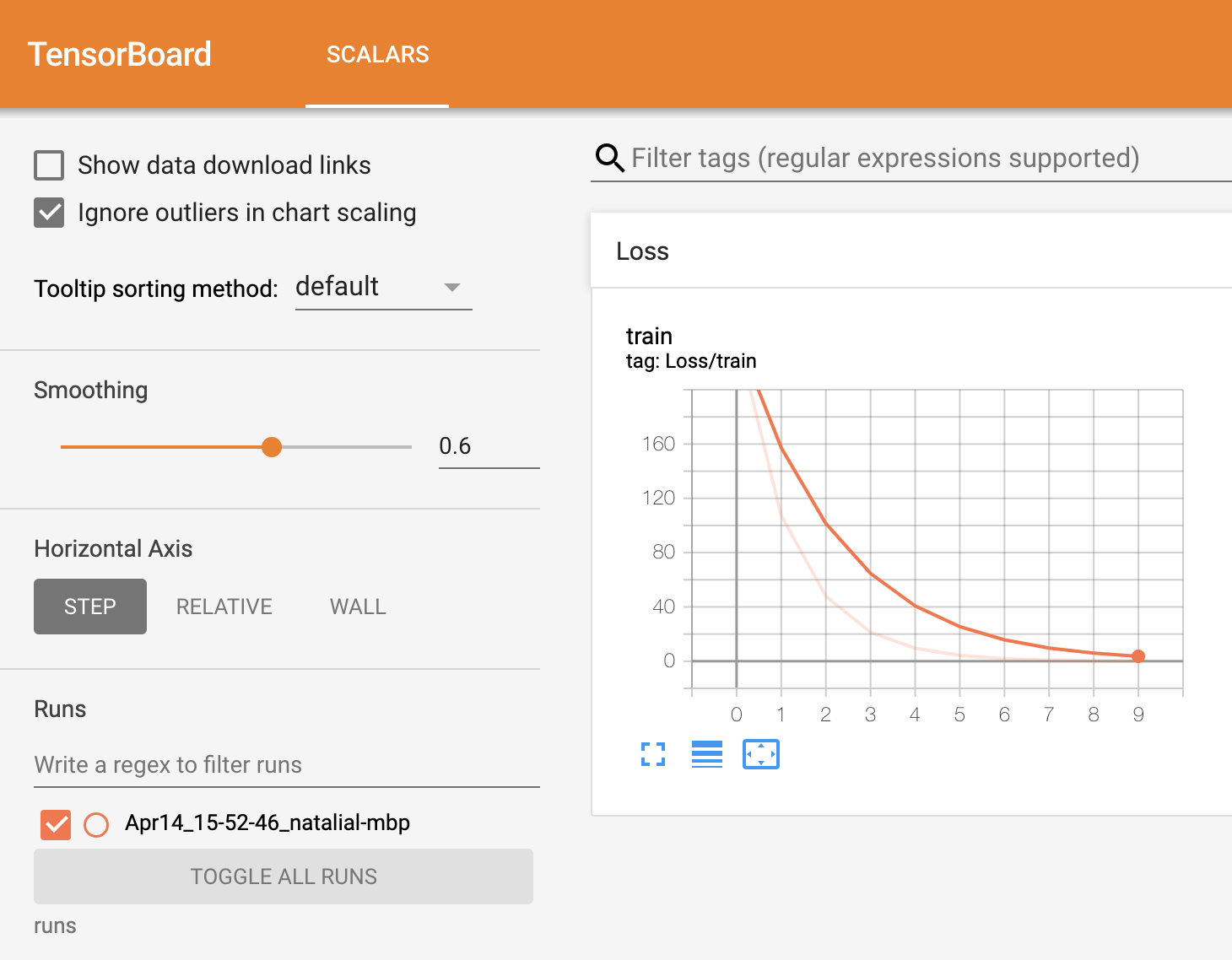

如何将 TensorBoard 与 PyTorch 结合使用

-

动态量化

-

用于部署的 TorchScript

了解如何以 TorchScript 格式导出经过训练的模型以及如何以 C++ 加载 TorchScript 模型并进行推理

-

使用 Flask 进行部署

-

支持 TorchScript 的分布式优化器

-

如何将 TensorBoard 与 PyTorch 结合使用